不同於行動裝置的 AI 測試還未有公認的測試基準,資料中心與超級電腦的 AI 性能在由多家業界領導廠商共同倡議下提供具公正性的測試基準 MLPerf ,包括 Arm,百度,Facebook,Google,哈佛,Intel,聯想,微軟,史丹佛大學,多倫多大學和 NVIDIA 皆是此測試標準的倡議者;而 NVIDIA 今年在 A100 GPU 與 Jetson AGX Xavier 推出後,於 MLPerf 測試再度突破先前紀錄,分別奪下資料中心與邊際運算的 AI 推論測試領先成績。

MLPerf 也持續因應市場需求持續增加與調整測試項目,此次也因應應用需求導入四項新測試,包括自然語言處理、醫學影像、推薦系統與語音辨識以及電腦視覺相關領域。

▲ NVIDIA A100 與 NVIDIA T4 在資料中心 AI 推論測試取得大幅領先

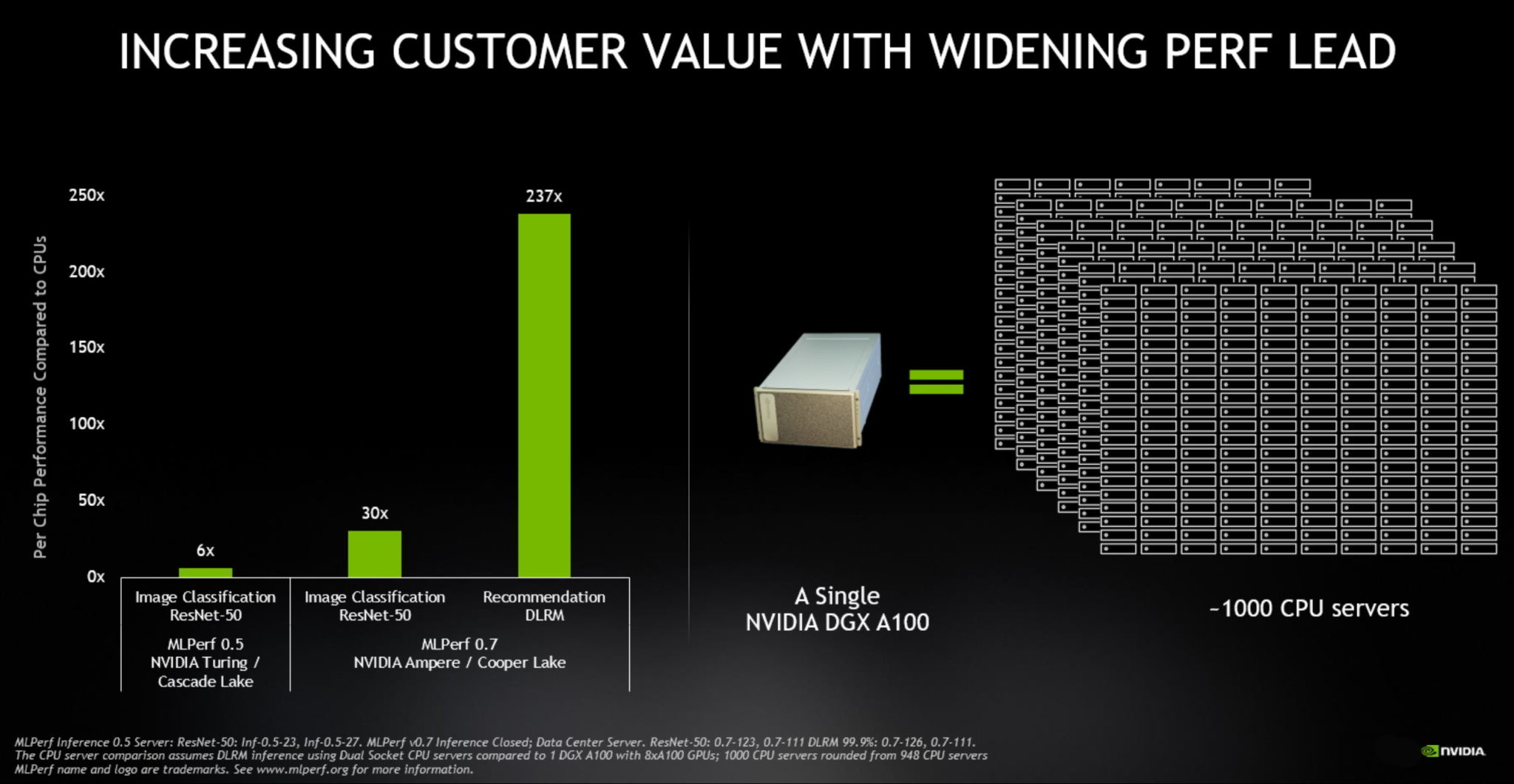

▲單一 NVIDIA DGX A100 可在特定 AI 領域媲美 1,000 台雙 CPU 插槽伺服器

以 MLPerf 當中的 MLPerf Inference 0.7 測試結果,甫於今年中推出的 A100 資料中心推論性能比起 CPU 達 237 倍性能,在相同的測試環節,縱使是訴求低功耗的 NVIDIA T4 GPU ,仍較 CPU 高出 28 倍性能;這也意味著載有 8 張 NVIDIA A100 GPU 的 NVIDIA DGX A100 超算系統能夠在特定 AI 應用與 1,000 台雙插槽的 CPU 伺服器有同等性能。

同時相較上一次提交測試報告僅 12 家組織,此次的測試參與組織成長快一倍,有 23 家組織提供測試報告,其中採用 NVIDIA AI 技術的合作夥伴提交達 871 份文件,佔 MLPerf 的資料中心與邊際 AI 測試文件總數的 85% 以上。不過雖然 NVIDIA A100 再度將性能達到高峰,但單就市場主流來說,小巧且具經濟效益的 NVIDIA T4 仍是當前多數企業首選。

▲ Jetson AGX Xavier 是少數能夠支援所有 AI 應用案例的邊際 AI 單晶片

另外,隨著邊際運算蓬勃發展,嵌入式 AI 推論亦成為市場關注的焦點, NVIDIA 的 NVIDIA Jetson AGX Xavier 雖屬於低功耗設計,但卻能夠支援所有的應用案例並具備全方位的高效能表現,也成為當前邊際運算最具性能與多元應用的單晶片。

▲今年雲端 GPU 的 AI 推論用量首度超越雲端 CPU

值得注意的是,由於武漢肺炎的影響, AI 技術在今年於醫學影像領域亦加速發展,無論是新創或是專業醫學團隊紛紛採用基於 AI 的影像分析技術,而 NVIDIA 在 MLPerf 的數據成績亦有助 IT 組織、開發人員制定專案與應用程式。同時在過去的 12 個月, NVIDIA GPU 於公有雲的 AI 推論終於超過雲端 CPU 的吞論效能,超過 100 exaflops 效能,以趨勢來看,每隔兩年雲端 GPU 的推論吞吐量即有 10 倍增長,意味 NVIDIA 的雲端 GPU 在效能、開發工具的易用度以及與公有雲服務的供應者、 AI 技術與虛擬畫技術開發廠商開發深度合作下,也使基於雲端 GPU 的 AI 技術需求遽增。

0 則回應