NVIDIA 在今年的 SC20 大會有三項主要宣示,其一是推出記憶體高達 80GB 的 NVIDIA A100 80GB 版 GPU ,其二是既有 DGX 系統也將隨之推出容量升級版,以及搭載 4 張 A100 80GB 版之 DGX Station A100 ,最後是 Mellanox 400G InfiniBand 。

搭載 NVIDIA A100 80GB 版的 DGX A100 、 DGX SA100 預計在本季開始出貨,而由系統商推出、搭載 4 或 8 個 NVIDIA A100 80GB 的系統則將在 2021 年上半年出貨; Mellanox 400G InfiniBand 預計在 2021 年第二季推出。

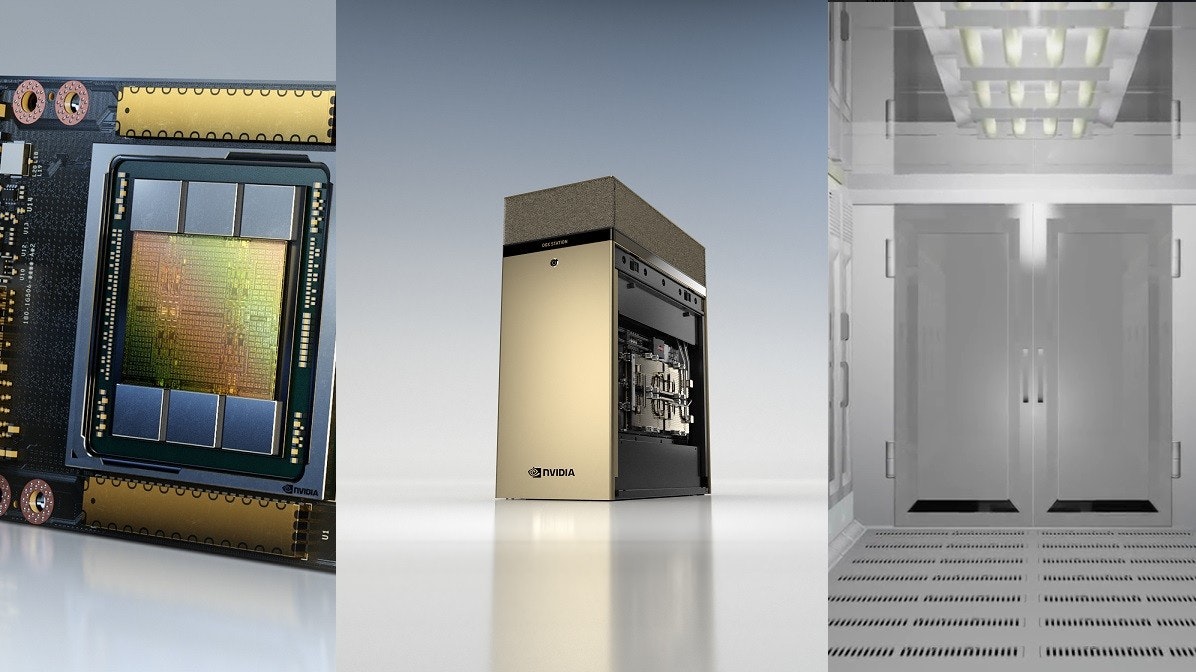

▲ NVIDIA A100 80GB 版採 80GB HBM2e 記憶體

NVIDIA A100 80GB 版本為今年所推出的 DGX A100 記憶體規格升級版本,不過除了記憶體自原本 40GB 倍增以外,亦採用全新的 HBM2e 記憶體,使其具備高達 2TBps 的記憶體頻寬,更大的記憶體容量與傳輸速度也帶來驚人的性能助益。

NVIDIA A100 80GB 版承襲 A100 特性,具備第三代 Tensor Core 、 MIG 技術、結構化稀疏、第三代 NVLink 與 NVSwitch 等;由翻倍的記憶體容量,能夠進行更龐大 AI 模型的訓練,如在 DLRM 的推薦系統模型,能夠相較原本 40GB 版本提升 3 倍訓練速度,同時也允許訓練更大型的模型,例如針對自然語言處理的 GPT-2 ,即可在單一 HGX 環境系統進行訓練,不需仰賴跨節點或是平行處理架構。

▲達 80GB 記憶體也進一步能在單一節點進行更複雜的 AI 訓練或是模擬以及分析運算

此外, NVIDIA A100 所支援的 MIG 多執行個體 GPU 技術也受惠於記憶體提升,原先的 7 個執行個體僅約略分配到 5GB 記憶體,現在則可分配到 10GB ,能夠構成高安全的硬體分隔區,對於像是 RNN-T 的自動語音辨識 AI 推論模型,能夠在單一執行個體處理更大量的批次。

在傳統數據分析領域,透過 80GB 大容量與高速頻寬, A100 80GB 版本在於零售大數據分析足以產生 2 倍效能;此外像是傳統應用如氣象預報、量子化學模擬,單一節點能夠提供將近 2 倍的效能。

同時

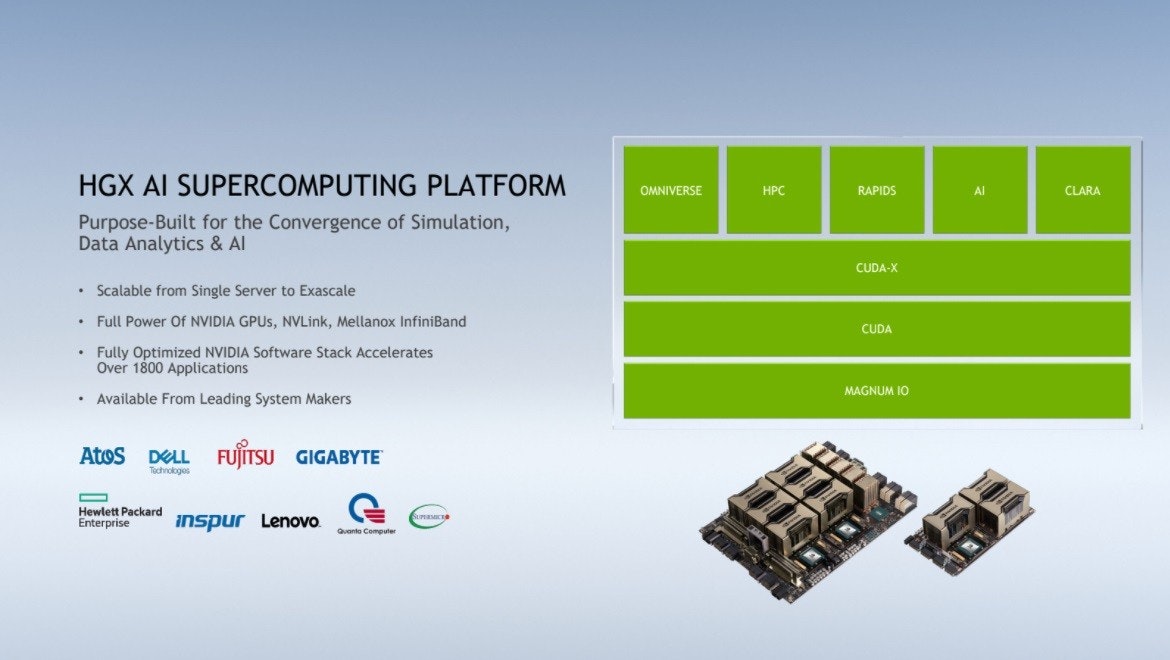

▲由第三方系統商推出、採 HGX 架構的 NVIDIA A100 80GB 版平台將在 2021 年初推出

▲藉由更龐大的記憶體,能使過去需要跨節點或並行處理的應用在單一 DGX A100 640GB 系統完成

隨著 NVIDIA A100 80GB 發表, NVIDIA DGX 超算系統也將隨之發表搭配 NVIDIA A100 80GB 版本的 DGX A100 640GB ,單一系統具備高達 640GB 的 VRAM ,對於記憶體需求較高的既有 NVIDIA DGX A100 320GB 用戶,則可選擇藉由付費硬體升級方式,將既有 40GB 版本 A100 替換為全新的 640GB 版本。

具備達 320GB VRAM 的 DGX Station A100

▲ DGX Station A100 以 AMD 64 核心 EPYC 搭配 4 張 NVIDIA A100 80GB GPU

NVIDIA 也藉由 SC20 宣布搭載 NVIDIA A100 的新一代整合 AI 伺服器 DGX Station A100 ,且一推出即可選擇甫發表的 A100 80GB 版本(亦提供 40GB 版本),使得單一伺服器具備 320GB VRAM ,對企業辦公室、研究機構、實驗室或家庭辦公室團隊能夠提供單一工作站突破 Petascale 等級的效能。

DGX Station A100 搭載 AMD 64 核心 EPYC 處理器,透過 PCIe 4.0 通道連接到 4 張以 NVLink 連接的 A100 80GB 版本,系統記憶體則達 512GB ,配有 1.92TB 之 NVMe SSD 。雖然效能高達 Petacscale 超算層級,不過 DGX Station A100 完全不需資料中心等集的電力與冷卻系統,同時具備與 NVIDIA DGX A100 超算系統相同的遠端管理功能。

當前包括 BMW Group Production 、德國人工智慧研究中心 DFKI 、洛克希德馬丁、太平洋西北國家實驗室等,皆宣布採用 DGX Station 進行創新。而全新一代的 DGX Station A100 相較上一世代的 DGX Station 整體效能大幅提升,應用在如 BERT Large 複雜對話式 AI 推論則具備 4 倍效能,用於訓練 BERT Large AI 模型可快近 3 倍。

Mellanox 400G InfiniBand

▲ Mellanox 400G InfiniBand 將扮演驅動未來運算重要關鍵

隸屬 NVIDIA 旗下的 Mellanox 400G InfiniBand 也藉此次 SC20 大會發表,為 Mellanox 第 7 世代的 InfiBand 技術,可提供超低延遲與 NDR 400GBps 的傳輸速度,同時透過 NVIDIA 往內運算引擎提供額外加速處理能力。

Mellanox 400G InfiniBand 將提供 3 倍的交換器埠密度,使 AI 加速可提升 32 倍,並使交換器系統聚合雙向處理量達到 1.64 petabit ,相較現行技術提高 5 倍。

▲ Mellanox 400G InfiniBand 進一步提升資料中心系統相互連接的速率

同時,透過第三代 NVIDIA Mellanox SHARP 技術,可使 InfiniBnad 網路針對 AI 作業負載的卸載作業減輕,並加速深度學習訓練作業,使 AI 加速力提升到 32 倍,配合 NVIDIA Magnum IO 軟體實現開箱即用的加速科學運算。

另外將 Mellanox 400G InfiniBand 架構應用在邊際交換器,可使聚合雙向處理量達 51.2Tbps ,並使每秒容量超過 655 億個封包,而在 Mellanox 400G InfiniBand 模組化交換器則可達到 1.64 prtabit 聚合雙向處理量,比起前一代提升 5 倍。但 Mellanox 400G InfiniBand 仍遵循˙ Mellanox InfiBand 業界標準,確保向前與向厚的相容性。

0 則回應